Letzte Neuigkeiten

Englische Version

Videos (2009-)

Jürgen Schmidhuber

IDSIA,

Galleria 2,

6928 Manno-Lugano,

Schweiz

Fax +41 58 666666 1

Fon +41 58 666666 2

Sec +41 58 666666 6

Sende Spam etc an

juergen@idsia.ch

Angelsachse, sprich: You_again Shmidhoobuh (kannst Du

Schwarzenegger &

Schumacher &

Schiffer sagen,

dann auch

Schmidhuber)

ONLINE SEIT 1405

(Moslemkalender)

Wiss. Dir. des IDSIA,

Prof. der KI @ USI,

Prof. SUPSI,

Chef des Cog Bot Labs

@ TUM,

Dr. rer. nat. habil. 1993 @ CU,

Dr. rer. nat. 1991,

Dipl. Inf. 1987

Wiss. Dir. des IDSIA,

Prof. der KI @ USI,

Prof. SUPSI,

Chef des Cog Bot Labs

@ TUM,

Dr. rer. nat. habil. 1993 @ CU,

Dr. rer. nat. 1991,

Dipl. Inf. 1987

Publikationen

Curriculum Vitae

Portrait (2010)

Mehr Bilder (1963-2007)

Arbeitsgruppe 2010

Jobs 2010 (3 Doktoren & 3 Doktoranden)

Jobs 2009 (5 Doktoren & 5 Doktoranden)

Mehr Jobs am IDSIA

FORSCHUNGSTHEMEN (mehr in den Spalten nebenan):

Rekurrente Neurale Netzwerke,

Mustererkennung,

Gödel Machinen,

Universelle KI,

Optimale Problemlöser,

Evolution,

Reinforcement Lernen (RL),

Hierarchisches RL,

Meta-Lernen,

Künstliche Neugier & Kreativität & Intrinsische Motivation & Robotik, Formale Theorie der Kreativität,

Formale Theorie der Schönheit,

Berechenbare Universen,

Verallgemeinerte Algorithmische Information

KURSE

Maschinelles Lernen 1

Maschinelles Lernen 2

Unsere

Pybrain ML Bibliothek enthält Quellcode für zahlreiche

neue Lernalgorithmen -

vgl. Pybrain video.

ROBOTER

Lernende Roboter,

elastische Roboter,

Roboter-bevölkerungsexplosion,

statistische Robotik,

robuste Maschinen,

resiliente Roboter (Science 316 p 688),

CoTeSys Roboter,

Cogbotlab,

Roboterautos

KAUM KOMPLEXE KUNST

Beispiel: Femme Fractale

(weitere Beispiele),

3D Kunst (Skulptur),

Lego Kunst: stabile Ringe aus LEGO-Ziegeln,

Kunst mit Kindern,

Bilder sich selbst verbessender Roboter: Stand der Kunst /

Zukunft / Ferne Zukunft

GESCHICHTE

Konvergiert die Geschichte? Schon wieder? (2006)

Beschleunigung der Rechnergeschichte -

Schmidhubers Gesetz: jeder neue Durchbruch

kommt doppelt so schnell - Omegapunkt um 2040.

KI Geschichte,

Colossus (Nature 441 p 25),

Telefon (Science 319 p 1759),

erster Motorflug (Nature 421 p 689)

LEUTE

Einstein (allgemeine Relativität, 1915),

Zuse (erster Computer, 1935-41),

Gödel (Grenzen der Mathematik und der Rechner, 1931),

Turing (Turingmaschine, 1936: Nature

429 p 501),

Gauss (Mathematiker des Jahrtausends),

Leibniz (Infinitesimalrechnung und Binärsystem),

Schickard (Vater des Rechnerzeitalters),

Solomonoff (Theorie optimaler Vorhersage),

Darwin (Nature 452 p 530),

Haber & Bosch (1913:

einflussreichste Erfindung des 20. Jahrhunderts),

Archimedes (grösster Wissenschaftler aller Zeiten?)

NOBELPREISE: Evolution nationaler Anteile nach

Geburtsland (bzw. Staatsbürgerschaft):

Frieden (bzw),

Literatur (bzw),

Medizin (bzw),

Chemie (bzw),

Physik (bzw),

Alle (bzw),

Wissenschaften (bzw),

Englisch & Deutsch

OLYMPIA

EU Gold (Peking 2008),

EU Metall (Athen 2004),

Alles Gold 1896-2010,

2008,

2006

China und einstige Imperien (Newsweek, 2004-05). Die

Europäische Union - eine neue Art Imperium? (2009)

FAMILIE

Ulrike Krommer (Frau)

Julia & Leonie (Kinder)

Schmidhubers

kleiner Bruder Christof,

der theoretische Physiker und Finanzguru.

Seine Artikel:

berühmtester /

lesbarster /

bester /

wildester;

seine Frau

Prof. Beliakova, Topologin.

Nie dem Ruhm so nah.

Bayerische Poesie

(perfekter Reim auf 8x4 Silben, und macht sogar Sinn)

Öffentliche Bar

Für alle Cartoons & Kunstwerke &

Fibonacci Web Design Schablonen

gilt:

Copyright © Jürgen Schmidhuber

(wenn nicht anders angegeben).

Alte Version dieser Seite

.

|

|

|

|

Seit seinem 15. Lebensjahr will Professor Jürgen Schmidhuber eine sich selbst verbessernde Künstliche Intelligenz (KI) bauen, die klüger ist als er selbst, um dann in Rente zu gehen. Seit 1987 publizierte er Pionierarbeiten zu universellen Problemlösern, seit 1991 zu "Deep Learning" mit tiefen künstlichen neuronalen Netzen (NN).

Die mächtigen rückgekoppelten NN seiner Forschungsgruppen an der TU München und am Schweizer KI Labor IDSIA (USI & SUPSI) waren die ersten, die internationale Wettbewerbe gewannen.

Die mächtigen rückgekoppelten NN seiner Forschungsgruppen an der TU München und am Schweizer KI Labor IDSIA (USI & SUPSI) waren die ersten, die internationale Wettbewerbe gewannen.

Sie revolutionierten Handschrifterkennung, Spracherkennung, maschinelle Übersetzung, automatische Bildbeschreibung, und viele andere wichtige Felder,

und sind nun Milliarden von Nutzern zugänglich durch Google, Microsoft, IBM, Baidu, und zahlreiche weitere Firmen.

DeepMind (für 600M an Google verkauft) wurde stark beeinflusst durch seine ehemaligen Doktoranden (2 der ersten 4 DeepMinder sowie DeepMinds erste Doktoren der KI studierten in seinem Labor, einer war Mitgründer, einer erster Angestellter). Die tiefen Lerner seines Teams waren die weltweit ersten, die Objektfindungs- und Bildsegmentierungswettbwerbe gewannen, u.a. zur Krebsfrüherkennung.

Sie erzielten 2011 im Silicon Valley auch die ersten übermenschlichen visuellen Mustererkennungsresultate.

Sie revolutionierten Handschrifterkennung, Spracherkennung, maschinelle Übersetzung, automatische Bildbeschreibung, und viele andere wichtige Felder,

und sind nun Milliarden von Nutzern zugänglich durch Google, Microsoft, IBM, Baidu, und zahlreiche weitere Firmen.

DeepMind (für 600M an Google verkauft) wurde stark beeinflusst durch seine ehemaligen Doktoranden (2 der ersten 4 DeepMinder sowie DeepMinds erste Doktoren der KI studierten in seinem Labor, einer war Mitgründer, einer erster Angestellter). Die tiefen Lerner seines Teams waren die weltweit ersten, die Objektfindungs- und Bildsegmentierungswettbwerbe gewannen, u.a. zur Krebsfrüherkennung.

Sie erzielten 2011 im Silicon Valley auch die ersten übermenschlichen visuellen Mustererkennungsresultate.

Seine Gruppe gewann neun internationale Wettstreite (mehr als jede andere), und schuf die ersten Verfahren, die ohne Lehrer

Steuerstrategien

direkt aus hochdimensionalen Videoeingaben lernten.

Sein Team etablierte weiterhin das Feld mathematisch rigoroser universeller KI und optimaler universeller Problemlöser.

Seine Gruppe gewann neun internationale Wettstreite (mehr als jede andere), und schuf die ersten Verfahren, die ohne Lehrer

Steuerstrategien

direkt aus hochdimensionalen Videoeingaben lernten.

Sein Team etablierte weiterhin das Feld mathematisch rigoroser universeller KI und optimaler universeller Problemlöser.

Seine formale Theorie der Kreativität und der Neugier erklärt erstmals Kunst, Wissenschaft, Musik und Humor.

Er verallgemeinerte die algorithmische Informationstheorie und auch die Vielweltentheorie der Physik, um eine elegante minimale Theorie aller konstruktiv berechenbarer Universen zu erhalten, und führte das Konzept der "Low-Complexity Art" ein, die extreme algorithmische Form der Minimalkunst. Seit 2009 ist er Mitglied der Europäischen Akademie der Wissenschaften und der Künste. Er publizierte 333 begutachtete Schriften, erhielt 7 best paper/best video Preise, den 2013 Helmholtz Award der International Neural Networks Society, und den 2016 IEEE Neural Networks Pioneer Award. Er ist auch Präsident der Firma NNAISENSE, die die erste praktische Allzweck-KI erschaffen will.

Ist das Ende

40,000-jähriger durch den Homo sapiens sapiens dominierter Geschichte in Sicht? Seine formale Theorie der Kreativität und der Neugier erklärt erstmals Kunst, Wissenschaft, Musik und Humor.

Er verallgemeinerte die algorithmische Informationstheorie und auch die Vielweltentheorie der Physik, um eine elegante minimale Theorie aller konstruktiv berechenbarer Universen zu erhalten, und führte das Konzept der "Low-Complexity Art" ein, die extreme algorithmische Form der Minimalkunst. Seit 2009 ist er Mitglied der Europäischen Akademie der Wissenschaften und der Künste. Er publizierte 333 begutachtete Schriften, erhielt 7 best paper/best video Preise, den 2013 Helmholtz Award der International Neural Networks Society, und den 2016 IEEE Neural Networks Pioneer Award. Er ist auch Präsident der Firma NNAISENSE, die die erste praktische Allzweck-KI erschaffen will.

Ist das Ende

40,000-jähriger durch den Homo sapiens sapiens dominierter Geschichte in Sicht?

| |

Künstliche rekurrente neuronale Netze.

Die meisten Arbeiten im Bereich des maschinellen

Lernens konzentrieren sich auf Maschinen mit

einfachem reaktivem Verhalten.

RNN sind allgemeinere,

dem menschlichen Gehirn

nachempfundene Sequenzverarbeiter. Durch

adaptive Rückkopplung sind sie im Prinzip so

mächtig wie irgendein Rechner.

Bis vor kurzem konnten RNN jedoch nicht lernen, weit

in die Vergangenheit zu blicken. Ein neuer RNN-Typ namens

"Long Short-Term Memory" (LSTM) überwindet jedoch fundamentale Probleme

traditioneller RNN,

Künstliche rekurrente neuronale Netze.

Die meisten Arbeiten im Bereich des maschinellen

Lernens konzentrieren sich auf Maschinen mit

einfachem reaktivem Verhalten.

RNN sind allgemeinere,

dem menschlichen Gehirn

nachempfundene Sequenzverarbeiter. Durch

adaptive Rückkopplung sind sie im Prinzip so

mächtig wie irgendein Rechner.

Bis vor kurzem konnten RNN jedoch nicht lernen, weit

in die Vergangenheit zu blicken. Ein neuer RNN-Typ namens

"Long Short-Term Memory" (LSTM) überwindet jedoch fundamentale Probleme

traditioneller RNN,

und lernt effizient so manche einst unlernbare

Aufgabe: Erkennung kontextsensitiver Sprachen,

automatische Handschrifterkennung (weltbeste Ergebnisse),

Aspekte der Sprachverarbeitung,

R-Lernen in partiell sichtbaren Umgebungen;

Metalernen,

Musikkomposition, Zeitreihenvorhersage.

Unsere RNN lernen durch

Gradienten oder

Evolution oder

beides (EVOLINO).

und lernt effizient so manche einst unlernbare

Aufgabe: Erkennung kontextsensitiver Sprachen,

automatische Handschrifterkennung (weltbeste Ergebnisse),

Aspekte der Sprachverarbeitung,

R-Lernen in partiell sichtbaren Umgebungen;

Metalernen,

Musikkomposition, Zeitreihenvorhersage.

Unsere RNN lernen durch

Gradienten oder

Evolution oder

beides (EVOLINO).

Gödelmaschine

oder

Gödel-Maschine.

Es ist ein alter Traum der Informatiker,

einen optimal effizienten universellen Problemlöser zu bauen.

Die neuartige Gödelmaschine (inspiriert durch Kurt

Gödels berühmte

selbstreferentielle Formeln, 1931) lässt sich

auf einem herkömmlichen Rechner implementieren

und löst beliebige Probleme

in theoretisch optimaler Weise.

Sie beginnt mit einer

axiomatischen Beschreibung ihrer selbst, was u.a.

auch eine beliebige formalisierbare Problemstellung

oder Gütefunktion mit einschliesst.

Gödelmaschine

oder

Gödel-Maschine.

Es ist ein alter Traum der Informatiker,

einen optimal effizienten universellen Problemlöser zu bauen.

Die neuartige Gödelmaschine (inspiriert durch Kurt

Gödels berühmte

selbstreferentielle Formeln, 1931) lässt sich

auf einem herkömmlichen Rechner implementieren

und löst beliebige Probleme

in theoretisch optimaler Weise.

Sie beginnt mit einer

axiomatischen Beschreibung ihrer selbst, was u.a.

auch eine beliebige formalisierbare Problemstellung

oder Gütefunktion mit einschliesst.

Mit Hilfe eines asymptotisch optimalen Theorembeweisers

überschreibt die Gödelmaschine

beliebige Teile ihrer Software

(samt dem Theorembeweiser), sobald

sie einen Beweis gefunden hat,

dass dies ihre zukünftige Leistung verbessern wird.

Ausgeführte Selbständerungen sind global

optimal (keine lokalen Minima!), da nachweislich keine der alternativen

Selbständerungen und Beweise (die man durch Fortsetzung

der Beweissuche finden könnte) das Warten wert sind.

Zusammenfassung. FAQ.

Mit Hilfe eines asymptotisch optimalen Theorembeweisers

überschreibt die Gödelmaschine

beliebige Teile ihrer Software

(samt dem Theorembeweiser), sobald

sie einen Beweis gefunden hat,

dass dies ihre zukünftige Leistung verbessern wird.

Ausgeführte Selbständerungen sind global

optimal (keine lokalen Minima!), da nachweislich keine der alternativen

Selbständerungen und Beweise (die man durch Fortsetzung

der Beweissuche finden könnte) das Warten wert sind.

Zusammenfassung. FAQ.

Optimaler Problemsequenzlöser.

OOPS (Kurzform des englischen Namens) löst ein

Problem nach dem anderen durch Suche

nach Programmen, die Lösungen berechnen. Die inkrementelle

Methode

nützt

in optimaler

Weise Lösungen älterer Probleme aus, wann immer dies möglich ist - vergleiche

Levins optimale universelle Suche.

OOPS kann temporär seine eigene Suchprozedur umschreiben und

eine schnellere Suchmethode suchen (Metasuche oder

Metalernen).

Anwendbar auf Probleme der Optimierung und Vorhersage.

Vortrag.

Optimaler Problemsequenzlöser.

OOPS (Kurzform des englischen Namens) löst ein

Problem nach dem anderen durch Suche

nach Programmen, die Lösungen berechnen. Die inkrementelle

Methode

nützt

in optimaler

Weise Lösungen älterer Probleme aus, wann immer dies möglich ist - vergleiche

Levins optimale universelle Suche.

OOPS kann temporär seine eigene Suchprozedur umschreiben und

eine schnellere Suchmethode suchen (Metasuche oder

Metalernen).

Anwendbar auf Probleme der Optimierung und Vorhersage.

Vortrag.

Super Omegas;

Generalisierte

Kolmogorov- Komplexität /

Algorithmische Wahrscheinlichkeit.

Kolmogorovs Komplexität K(x) eines Bitstrings x ist die Länge

des kürzesten Programms, das x berechnet und

hält. Solomonoffs

algorithmische Wahrscheinlichkeit von x ist die Chance,

ein Programm für x zu raten. Chaitins Omega ist die

Haltewahrscheinlichkeit

einer Turingmaschine mit zufälliger Eingabe (Omega kennt man als

die "Zahl der Weisheit", da sie kompakt alle mathematische Wahrheit kodiert).

Schmidhuber generalisierte all dies zu nichthaltenden, doch konvergierenden

Programmen. Dies führte zu den kürzesten

möglichen formalen Beschreibungen, und zu nicht aufzählbaren, doch

im Limit berechenbaren W-Massen und Super-Omegas. Hat sogar

Konsequenzen für berechenbare Universen und

optimale induktive Inferenz. Vortrag.

Super Omegas;

Generalisierte

Kolmogorov- Komplexität /

Algorithmische Wahrscheinlichkeit.

Kolmogorovs Komplexität K(x) eines Bitstrings x ist die Länge

des kürzesten Programms, das x berechnet und

hält. Solomonoffs

algorithmische Wahrscheinlichkeit von x ist die Chance,

ein Programm für x zu raten. Chaitins Omega ist die

Haltewahrscheinlichkeit

einer Turingmaschine mit zufälliger Eingabe (Omega kennt man als

die "Zahl der Weisheit", da sie kompakt alle mathematische Wahrheit kodiert).

Schmidhuber generalisierte all dies zu nichthaltenden, doch konvergierenden

Programmen. Dies führte zu den kürzesten

möglichen formalen Beschreibungen, und zu nicht aufzählbaren, doch

im Limit berechenbaren W-Massen und Super-Omegas. Hat sogar

Konsequenzen für berechenbare Universen und

optimale induktive Inferenz. Vortrag.

Universelle Lernalgorithmen.

Es gibt einen theoretisch optimalen Weg,

die Zukunft vorherzusagen, vorausgesetzt,

die unbekannten probabilistischen Gesetze der

Umgebung sind im Prinzip berechenbar.

Daraus ergibt sich ein optimaler (jedoch

leider nicht mehr berechenbarer) rationaler Agent, der

in fast beliebigen Umgebungen seinen zu erwartenden

Erfolg maximiert. Diese Arbeit repräsentiert

die erste mathematisch saubere Theorie

universeller künstlicher Intelligenz

(frühere KI-Ansätze waren entweder heuristisch oder

sehr beschränkt).

Universelle Lernalgorithmen.

Es gibt einen theoretisch optimalen Weg,

die Zukunft vorherzusagen, vorausgesetzt,

die unbekannten probabilistischen Gesetze der

Umgebung sind im Prinzip berechenbar.

Daraus ergibt sich ein optimaler (jedoch

leider nicht mehr berechenbarer) rationaler Agent, der

in fast beliebigen Umgebungen seinen zu erwartenden

Erfolg maximiert. Diese Arbeit repräsentiert

die erste mathematisch saubere Theorie

universeller künstlicher Intelligenz

(frühere KI-Ansätze waren entweder heuristisch oder

sehr beschränkt).

Speed Prior.

Occams Rasiermesser: ziehe einfache Lösungen den komplexen vor!

Aber was heisst einfach?

Aus traditioneller Sichtweise haben einfache Dinge eine kurze

Beschreibung oder ein kurzes Programm und damit niedrige

Kolmogorov-Komplexität.

Dies führt zu

Solomonoffs & Levins berühmtem

a priori W-Mass, welches

zwar optimale, jedoch nicht- berechenbare Vorhersagen

aus vergangenen Beobachtungen erlaubt.

Die Speed Prior

ist ein neues Einfachheitsmass basierend auf

den schnellsten Beschreibungen, nicht den kürzesten.

Führt zu nahezu optimalen berechenbaren Vorhersagen,

und zu ungewöhnlichen Prophezeihungen über die Zukunft des Universums.

Vortrag.

Speed Prior.

Occams Rasiermesser: ziehe einfache Lösungen den komplexen vor!

Aber was heisst einfach?

Aus traditioneller Sichtweise haben einfache Dinge eine kurze

Beschreibung oder ein kurzes Programm und damit niedrige

Kolmogorov-Komplexität.

Dies führt zu

Solomonoffs & Levins berühmtem

a priori W-Mass, welches

zwar optimale, jedoch nicht- berechenbare Vorhersagen

aus vergangenen Beobachtungen erlaubt.

Die Speed Prior

ist ein neues Einfachheitsmass basierend auf

den schnellsten Beschreibungen, nicht den kürzesten.

Führt zu nahezu optimalen berechenbaren Vorhersagen,

und zu ungewöhnlichen Prophezeihungen über die Zukunft des Universums.

Vortrag.

Am Anfang war der Code.

1997 schrieb Schmidhuber den ersten Artikel

über das Ensemble der möglichen berechenbaren Universen. Sein

Grosser Programmierer

verträgt sich mit Zuses

Hypothese (1967) der berechenbaren Physik, gegen die keine

physikalische Evidenz vorliegt. Welches ist das Programm, das unsere Welt berechnet?

Es stellt sich heraus, dass das einfachste

Programm alle Universen

berechnet, nicht nur unseres. Spätere Arbeiten

(2000) zum Thema

Algorithmische Theorien des Alls analysierten alle

Universen mit im Limit berechenbaren Wahrscheinlichkeiten und

die Grenzen formaler Beschreibbarkeit. Dies führte

zu obigen Verallgemeinerungen algorithmischer Information

und dem Super Omega und auch zur

Speed Prior. Das

durchsuchbare

"everything" Archiv

enthält zahlreiche Diskussionen dieser Arbeiten.

Vgl. Artikel im

Spiegel und

Kommentare zu Wolframs Buch (2002) sowie

diesen Brief zum Zufall in der

Physik (Nature 439, 2006).

Vortrag.

Am Anfang war der Code.

1997 schrieb Schmidhuber den ersten Artikel

über das Ensemble der möglichen berechenbaren Universen. Sein

Grosser Programmierer

verträgt sich mit Zuses

Hypothese (1967) der berechenbaren Physik, gegen die keine

physikalische Evidenz vorliegt. Welches ist das Programm, das unsere Welt berechnet?

Es stellt sich heraus, dass das einfachste

Programm alle Universen

berechnet, nicht nur unseres. Spätere Arbeiten

(2000) zum Thema

Algorithmische Theorien des Alls analysierten alle

Universen mit im Limit berechenbaren Wahrscheinlichkeiten und

die Grenzen formaler Beschreibbarkeit. Dies führte

zu obigen Verallgemeinerungen algorithmischer Information

und dem Super Omega und auch zur

Speed Prior. Das

durchsuchbare

"everything" Archiv

enthält zahlreiche Diskussionen dieser Arbeiten.

Vgl. Artikel im

Spiegel und

Kommentare zu Wolframs Buch (2002) sowie

diesen Brief zum Zufall in der

Physik (Nature 439, 2006).

Vortrag.

Lernende Roboter.

Manche

Roboter

tun erstaunliche Dinge.

Aber sie

sind vorprogrammiert, statt zu

lernen wie die Babys.

Traditionelle

R-Lernverfahren

beschränken sich nämlich

auf simples reaktives Vehalten. Daher funktionieren

sie bei realistischen Robotern kaum. Letztere brauchen

neue Lernmethoden, um wichtige vergangene Ereignisse

zu identifizieren und zu speichern, bis die Erinnerungen

gebraucht werden.

Lernende Roboter.

Manche

Roboter

tun erstaunliche Dinge.

Aber sie

sind vorprogrammiert, statt zu

lernen wie die Babys.

Traditionelle

R-Lernverfahren

beschränken sich nämlich

auf simples reaktives Vehalten. Daher funktionieren

sie bei realistischen Robotern kaum. Letztere brauchen

neue Lernmethoden, um wichtige vergangene Ereignisse

zu identifizieren und zu speichern, bis die Erinnerungen

gebraucht werden.

Schmidhubers Gruppe konzentriert sich hierbei auf

RNN,

RNN-Evolution,

und OOPS.

Sie arbeitet(e) an attentiver Sensorik,

hierarchischer Steuerung

und Policy Gradients. Sie

kollaboriert(e)

mit UniBW bei Roboterautos

und mit TUM-AM bei Humanoiden

(vgl. CoTeSys).

Neue Projekte

mit kreativen Robotern und neugierigen

adaptiven Humanoiden

sowie mit DLRs Kunsthänden

begannen 2009.

Schmidhubers Gruppe konzentriert sich hierbei auf

RNN,

RNN-Evolution,

und OOPS.

Sie arbeitet(e) an attentiver Sensorik,

hierarchischer Steuerung

und Policy Gradients. Sie

kollaboriert(e)

mit UniBW bei Roboterautos

und mit TUM-AM bei Humanoiden

(vgl. CoTeSys).

Neue Projekte

mit kreativen Robotern und neugierigen

adaptiven Humanoiden

sowie mit DLRs Kunsthänden

begannen 2009.

| |

Künstliche Evolution.

Die besten Methoden zur Evolution neuronaler Netze

ko-evolvieren alle

Neuronen gleichzeitig (exzellente Resultate in zahlreichen Anwendungen

zur adaptiven Agentensteuerung).

EVOLINO

übertrifft ältere Methoden bei vielen überwachten Lernaufgaben,

und liefert die ersten rekurrenten Stützvektormaschinen.

Probabilistische

inkrementelle Programmevolution evolviert

Künstliche Evolution.

Die besten Methoden zur Evolution neuronaler Netze

ko-evolvieren alle

Neuronen gleichzeitig (exzellente Resultate in zahlreichen Anwendungen

zur adaptiven Agentensteuerung).

EVOLINO

übertrifft ältere Methoden bei vielen überwachten Lernaufgaben,

und liefert die ersten rekurrenten Stützvektormaschinen.

Probabilistische

inkrementelle Programmevolution evolviert

Software durch probabilistische Schablonen statt Programmpopulationen

(der erste tabula rasa Ansatz zum Erlernen ganzer Fussballteamstrategien.)

Als Student implementierte Schmidhuber auch das erste System für

Genetische Programmierung mit

bedingten Sprüngen und variabler Codelänge (1987, siehe unten).

Software durch probabilistische Schablonen statt Programmpopulationen

(der erste tabula rasa Ansatz zum Erlernen ganzer Fussballteamstrategien.)

Als Student implementierte Schmidhuber auch das erste System für

Genetische Programmierung mit

bedingten Sprüngen und variabler Codelänge (1987, siehe unten).

Was macht manche Dinge interessant? Schmidhuber's Arbeiten zu

künstlicher Neugier liefern die Antwort

und beschreiben, wie man künstliche Forscher & Künstler baut.

Seine

neugierige Agenten

gehen dorthin, wo sie

erwarten können, was zu lernen. Sie verlieren das Interesse

sowohl an vorhersagbaren als auch unvorhersagbaren Dingen.

Was macht manche Dinge interessant? Schmidhuber's Arbeiten zu

künstlicher Neugier liefern die Antwort

und beschreiben, wie man künstliche Forscher & Künstler baut.

Seine

neugierige Agenten

gehen dorthin, wo sie

erwarten können, was zu lernen. Sie verlieren das Interesse

sowohl an vorhersagbaren als auch unvorhersagbaren Dingen.

Die

zugehörige

formale Theorie der Kreativität

erklärt

Wissenschaft, Kunst,

Musik und Humor.

Die

zugehörige

formale Theorie der Kreativität

erklärt

Wissenschaft, Kunst,

Musik und Humor.

Erlernen selektiver Vision.

Menschen und andere

biologische Systeme erkennen Muster durch sequentielle Augenbewegungen.

Dies kann viel effizienter sein als vollständig parallele

Ansätze zum maschinellen Sehen. 1990 bauten wir

die erste künstliche Fovea, die durch ein adaptives neuronales Netz

gesteuert wird und ohne Lehrer lernt, Zielobjekte in einer visuellen

Szene zu finden, oder bewegliche Ziele zu verfolgen.

R-Lernen in

partiell sichtbaren Welten.

R-Lerner versuchen

stets, ihr in Zukunft zu erwartendes Glück zu

maximieren und das zu erwartende Leid zu minimieren.

Frühere Arbeiten beschränkten sich meist auf

das Erlernen reaktiver Abbildungen von Wahrnehmungen auf Aktionen.

Unsere Methoden (seit 1989)

sind allgemeiner: sie erlernen geeignete interne Zustände,

manchmal auch durch Evolution von RNN.

Der erste universelle R-Lerner

ist optimal, wenn wir seine exorbitante Rechenzeit vernachlässigen. Und hier

ist einer, der auch sonst optimal ist.

R-Lernen in

partiell sichtbaren Welten.

R-Lerner versuchen

stets, ihr in Zukunft zu erwartendes Glück zu

maximieren und das zu erwartende Leid zu minimieren.

Frühere Arbeiten beschränkten sich meist auf

das Erlernen reaktiver Abbildungen von Wahrnehmungen auf Aktionen.

Unsere Methoden (seit 1989)

sind allgemeiner: sie erlernen geeignete interne Zustände,

manchmal auch durch Evolution von RNN.

Der erste universelle R-Lerner

ist optimal, wenn wir seine exorbitante Rechenzeit vernachlässigen. Und hier

ist einer, der auch sonst optimal ist.

Nichtlineare ICA.

Mustererkennung geht besser, wenn die

Daten redundanzarm sind und aus unabhängigen

Teilen bestehen.

Schmidhubers

Vorhersagbarkeits- Minimierung

(1992) war der erste nichtlineare neuronale Algorithmus zum Erlernen

redundanzarmer Datenumformungen.

Er beruht auf Koevolution sich bekämpfender Prediktoren und

Detektoren:

die letzteren versuchen, Aspekte der Daten

zu kodieren, die sie unvorhersagbar machen.

Neuronale

Geschichtskompressoren

(1991) kodieren auch sequentielle Daten kompakt. Und

Lococode vereinigt Regularisierung

und unüberwachtes Lernen.

Nichtlineare ICA.

Mustererkennung geht besser, wenn die

Daten redundanzarm sind und aus unabhängigen

Teilen bestehen.

Schmidhubers

Vorhersagbarkeits- Minimierung

(1992) war der erste nichtlineare neuronale Algorithmus zum Erlernen

redundanzarmer Datenumformungen.

Er beruht auf Koevolution sich bekämpfender Prediktoren und

Detektoren:

die letzteren versuchen, Aspekte der Daten

zu kodieren, die sie unvorhersagbar machen.

Neuronale

Geschichtskompressoren

(1991) kodieren auch sequentielle Daten kompakt. Und

Lococode vereinigt Regularisierung

und unüberwachtes Lernen.

Metalerner / Lernen lernen / Selbstverbesserung.

Kann man Maschinen bauen, die bessere Lernmethoden lernen?

Diese Frage

trieb

Schmidhubers Forschungen seit seiner 1987er

Diplomarbeit.

1993 führte er

selbstreferentielle Gewichtsmatrizen ein, und

1994 selbstmodifizierende Strategien,

die durch den

"Success-Story Algorithmus"

trainiert werden

(Vortrag).

Sein erster in gewissem Sinne optimaler Metalearner

war der bereits erwähnte

OOPS (2002),

und sein ultimativer Metalearner ist die

Gödel-Maschine (2003).

Metalerner / Lernen lernen / Selbstverbesserung.

Kann man Maschinen bauen, die bessere Lernmethoden lernen?

Diese Frage

trieb

Schmidhubers Forschungen seit seiner 1987er

Diplomarbeit.

1993 führte er

selbstreferentielle Gewichtsmatrizen ein, und

1994 selbstmodifizierende Strategien,

die durch den

"Success-Story Algorithmus"

trainiert werden

(Vortrag).

Sein erster in gewissem Sinne optimaler Metalearner

war der bereits erwähnte

OOPS (2002),

und sein ultimativer Metalearner ist die

Gödel-Maschine (2003).

Finanzvorhersage.

Unsere lukrativste Anwendung neuronaler Netze

verwendet eine Methode zweiter Ordnung,

um das einfachste Modell gegebener Aktienmarktdaten zu finden.

Automatische Subzielfinder und Hierarchie-Lernen.

Kein Lehrer zeigt unseren

lernenden Maschinen gute Subziele.

In den frühen 1990ern führten wir

gradientenbasierte

adaptive Subzielfinder ein (Bilder),

später auch diskrete.

Automatische Subzielfinder und Hierarchie-Lernen.

Kein Lehrer zeigt unseren

lernenden Maschinen gute Subziele.

In den frühen 1990ern führten wir

gradientenbasierte

adaptive Subzielfinder ein (Bilder),

später auch diskrete.

Programmevolution und Genetische Programme.

Als Werkstudent der

SIEMENS AG

verwendete Schmidhuber Genetische Algorithmen,

um Programme auf einer Symbolics LISP-Maschine zu

evolvieren.

Zwei Jahre später führte dies zur weltweit

zweiten Arbeit zum

Thema "Genetische Programmierung" (GP, die erste war Cramers, 1985),

sowie zur weltweit ersten Meta-GP-Arbeit.

Programmevolution und Genetische Programme.

Als Werkstudent der

SIEMENS AG

verwendete Schmidhuber Genetische Algorithmen,

um Programme auf einer Symbolics LISP-Maschine zu

evolvieren.

Zwei Jahre später führte dies zur weltweit

zweiten Arbeit zum

Thema "Genetische Programmierung" (GP, die erste war Cramers, 1985),

sowie zur weltweit ersten Meta-GP-Arbeit.

Lernende Ökonomien

ohne Inflation.

In den späten 1980ern entwickelte Schmidhuber die ersten

künstlichen, die

Geldmenge konservierenden, lernenden

Marktwirtschaften, und auch

die erste neuronale.

Schnelle Gewichte statt rekurrenter Netze.

Ein sich langsam änderndes

Netz lernt, die sich schnell ändernden Synapsen eines

weiteren Netzes flott zu manipulieren.

Mehr zu schnellen Synapsen und zur

Evolution der Steuerung

schneller Synapsen.

Schnelle Gewichte statt rekurrenter Netze.

Ein sich langsam änderndes

Netz lernt, die sich schnell ändernden Synapsen eines

weiteren Netzes flott zu manipulieren.

Mehr zu schnellen Synapsen und zur

Evolution der Steuerung

schneller Synapsen.

Neuronaler Wärmetauscher.

Wie ein physikalischer Wärmetauscher,

aber mit Neuronen statt Wasser.

Wahrnehmungen erwärmen sich, Erwartungen kühlen ab.

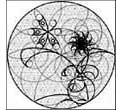

Komplexitätsbasierte Theorie der Schönheit.

1997 behauptete Schmidhuber: Unter mehreren als "vergleichbar"

klassifizierten Mustern ist das subjektiv schönste

das mit der kürzesten Beschreibung in

der Musterkodiersprache des subjektiven Beobachters.

Beispiele:

Simple Gesichter

und Kaum Komplexe Kunst,

die Minimalkunst des Informationszeitalters (Leonardo, 1997).

Ein kaum komplexes Kunstwerk wie diese Femme Fractale sieht

"richtig" aus und ist trotzdem durch ein

kurzes Programm berechenbar.

Den Drang, solche und andere Kunst zu erschaffen, erklärt die

formale Theorie der Kreativität.

Komplexitätsbasierte Theorie der Schönheit.

1997 behauptete Schmidhuber: Unter mehreren als "vergleichbar"

klassifizierten Mustern ist das subjektiv schönste

das mit der kürzesten Beschreibung in

der Musterkodiersprache des subjektiven Beobachters.

Beispiele:

Simple Gesichter

und Kaum Komplexe Kunst,

die Minimalkunst des Informationszeitalters (Leonardo, 1997).

Ein kaum komplexes Kunstwerk wie diese Femme Fractale sieht

"richtig" aus und ist trotzdem durch ein

kurzes Programm berechenbar.

Den Drang, solche und andere Kunst zu erschaffen, erklärt die

formale Theorie der Kreativität.

Künstliche Ameisen.

IDSIA's künstliche Ameisen sind

mit lokalen Suchtechniken ausgestattete

Multiagenten- Optimierer, die

mittels langsam verdampfender

künstlicher Pheromone kommunizieren.

Sie brachen mehrere wichtige

technische Weltrekorde. Hierzu gab es

zahlreiche Meldungen in Zeitschriften wie

Spiegel, Nature, Science, Scientific American, TIME,

NY Times, Economist, etc. IDSIA Spin-Off Firma:

ANTOPTIMA.

Künstliche Ameisen.

IDSIA's künstliche Ameisen sind

mit lokalen Suchtechniken ausgestattete

Multiagenten- Optimierer, die

mittels langsam verdampfender

künstlicher Pheromone kommunizieren.

Sie brachen mehrere wichtige

technische Weltrekorde. Hierzu gab es

zahlreiche Meldungen in Zeitschriften wie

Spiegel, Nature, Science, Scientific American, TIME,

NY Times, Economist, etc. IDSIA Spin-Off Firma:

ANTOPTIMA.

| |

|

|

|