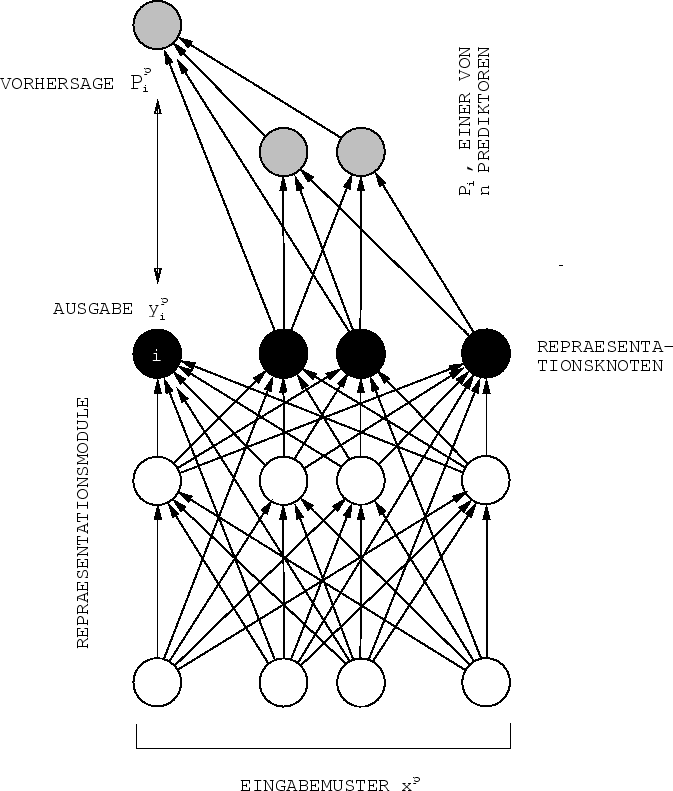

Für jeden Repräsentationsknoten

![]() führen wir

ein zusätzliches azyklisches adaptives (im allgemeinen nicht-lineares)

Prediktornetzwerk

führen wir

ein zusätzliches azyklisches adaptives (im allgemeinen nicht-lineares)

Prediktornetzwerk ![]() ein.

Beim

ein.

Beim ![]() -ten Eingabevektor

-ten Eingabevektor ![]() ist

ist

![]() 's Eingabevektor die

's Eingabevektor die

![]() -dimensionale Konkatenation aller Ausgaben

-dimensionale Konkatenation aller Ausgaben

![]() aller Repräsentationsknoten

aller Repräsentationsknoten ![]() .

.

![]() sieht also alle Repräsentationsknoten außer dem

von

sieht also alle Repräsentationsknoten außer dem

von ![]() vorherzusagenden Knoten mit Nummer

vorherzusagenden Knoten mit Nummer ![]() . Siehe Abbildung 6.1.

. Siehe Abbildung 6.1.

![]() 's ein-dimensionale Ausgabe

's ein-dimensionale Ausgabe ![]() wird mittels BP daraufhin trainiert, sich dem bedingten Erwartungswert

wird mittels BP daraufhin trainiert, sich dem bedingten Erwartungswert

![]() anzugleichen.

Dieses Ziel kann dadurch erreicht werden, daß

man

anzugleichen.

Dieses Ziel kann dadurch erreicht werden, daß

man ![]() die altbekannte Zielfunktion

die altbekannte Zielfunktion

|

(6.2) |

|

Das ist schon die grundlegende Topologie, die für

alle im Rest dieses Kapitels auftretenden Performanzmaße

und Algorithmen gleichbleiben wird. Die ![]() Prediktoren

dienen dazu, die Redundanz unter den Repräsentationsknoten

zu messen.

Mit Hilfe der

Prediktoren

dienen dazu, die Redundanz unter den Repräsentationsknoten

zu messen.

Mit Hilfe der ![]() (bezüglich ihrer Eingaben

differenzierbaren) Prediktoren lassen sich nun zusätzliche

differenzierbare Zielfunktionen für die Repräsentationsknoten

definieren (siehe Abschnitte 6.3 und 6.4), so daß

diese gedrängt werden, den drei Kriterien

aus Abschnitt 6.1 Genüge zu tun und faktorielle

Eingabecodierungen zu entdecken.

Allen diesen zusätzlichen Zielfunktionen für die Repräsentationsmodule

ist eines gemeinsam: Sie zwingen die Codeknoten, die

wechselseitige Vorhersagbarkeit durch die Prediktoren

zu minimieren.

(bezüglich ihrer Eingaben

differenzierbaren) Prediktoren lassen sich nun zusätzliche

differenzierbare Zielfunktionen für die Repräsentationsknoten

definieren (siehe Abschnitte 6.3 und 6.4), so daß

diese gedrängt werden, den drei Kriterien

aus Abschnitt 6.1 Genüge zu tun und faktorielle

Eingabecodierungen zu entdecken.

Allen diesen zusätzlichen Zielfunktionen für die Repräsentationsmodule

ist eines gemeinsam: Sie zwingen die Codeknoten, die

wechselseitige Vorhersagbarkeit durch die Prediktoren

zu minimieren.

Jeder Repräsentationsknoten versucht dabei, aus der

Umgebung irgendwelche Eigenschaften zu extrahieren, so daß keine

Kombination von ![]() Knoten Information (im Shannonschen Sinne)

über den

verbleibenden Knoten trägt.

Mit anderen Worten: Keine

auf der Kombination von

Knoten Information (im Shannonschen Sinne)

über den

verbleibenden Knoten trägt.

Mit anderen Worten: Keine

auf der Kombination von ![]() Repräsentationsknoten

basierende

Vorhersage des verbleibenden Knotens

sollte höhere Qualität aufweisen als

eine Vorhersage, die ohne Wissen über

die

Repräsentationsknoten

basierende

Vorhersage des verbleibenden Knotens

sollte höhere Qualität aufweisen als

eine Vorhersage, die ohne Wissen über

die ![]() Knoten auskommt.

Im folgenden werde ich dieses Prinzip das

Prinzip der intra-repräsentationellen Vorhersagbarkeitsminimierung

oder kürzer

das Prinzip der Vorhersagbarkeitsminimierung

nennen.

Knoten auskommt.

Im folgenden werde ich dieses Prinzip das

Prinzip der intra-repräsentationellen Vorhersagbarkeitsminimierung

oder kürzer

das Prinzip der Vorhersagbarkeitsminimierung

nennen.

Dem Prinzip der Vorhersagbarkeitsminimierung folgend versucht jeder Repräsentationsknoten, die statistischen Eigenschaften der Umgebung dergestalt auszunützen, daß er sich selbst vor Vorhersagbarkeit schützt. Jedes Repräsentationsmodul `will' sich auf Aspekte der Umgebung konzentrieren, die unabhängig von denjenigen abstrakten Umgebungseigenschaften sind, auf die sich die Aufmerksamkeit der restlichen Module lenkt.