82 verschiedene Zeichen (Kleinbuchstaben, Großbuchstaben, Ziffern

und Sonderzeichen) wurden jeweils durch ein aus ![]() Pixeln

bestehendes Bild repräsentiert (die Bilder entstammten dem

DEC courier Datensatz).

Jedes Pixel war entweder schwarz oder weiß. Damit ließen sich die

Buchstabenbilder als 150-dimensionale Binärvektoren darstellen, deren

Pixeln

bestehendes Bild repräsentiert (die Bilder entstammten dem

DEC courier Datensatz).

Jedes Pixel war entweder schwarz oder weiß. Damit ließen sich die

Buchstabenbilder als 150-dimensionale Binärvektoren darstellen, deren

![]() -te Komponente gleich 1 war, falls das entsprechende Pixel schwarz war,

und 0 sonst. Die 82 Binärvektoren dienten als die Eingabevektoren

-te Komponente gleich 1 war, falls das entsprechende Pixel schwarz war,

und 0 sonst. Die 82 Binärvektoren dienten als die Eingabevektoren ![]() für die

Repräsentationsmodule. Ihre Auftretenswahrscheinlichkeiten

sind in Tabelle 6.1 aufgelistet (siehe auch [5]).

für die

Repräsentationsmodule. Ihre Auftretenswahrscheinlichkeiten

sind in Tabelle 6.1 aufgelistet (siehe auch [5]).

|

Um die Performanz der Methode zur Redundanzreduktion zu analysieren, wurden folgende Maße verwendet:

1. Maß der Informationstransmission:

Um zu messen, wieviel Information

über das Eingabeensemble nach dem Training durch das Netzwerk an die

(binären) Repräsentationsknoten übermittelt wird, mißt man die

wechselseitige Information zwischen Eingabe und Codierung

| (6.11) |

| (6.12) |

2. Abhängigkeitsmaß:

Um zu messen, wie sehr die Codekomponenten nach dem Training

voneinander abhängen, berechnet man

| (6.13) |

3. Redundanzmaß:

Schließlich definieren wir das Maß der Redundanz ![]() einer

Binärcodierung durch die Differenz zwischen der tatsächlichen Entropie

des Codes und der maximal möglichen Entropie eines Binärcodes mit

ebensovielen Komponenten:

einer

Binärcodierung durch die Differenz zwischen der tatsächlichen Entropie

des Codes und der maximal möglichen Entropie eines Binärcodes mit

ebensovielen Komponenten:

| (6.14) |

Die folgenden Experimente zeigen die Performanz des Systems in Abhängigkeit von der Anzahl der Codekomponenten (der Anzahl der Repräsentationsknoten):

Experiment 11:

`on-line',

150 Eingabeknoten, ein zusätzlicher Eingabeknoten mit konstanter

Aktivation 1.0 (der `bias'-Knoten),

8 Repräsentationsknoten,

keine versteckten Knoten für die Repräsentationsmodule,

ebensoviele versteckte Knoten pro Prediktor wie Prediktoreingabeknoten,

Prediktorenlernrate 1.0,

Repräsentationsmodullernrate 0.1,

Verzicht auf Fehlerrückpropagierung durch Prediktoreneingabeknoten.

10 Testläufe mit je 10000 Musterdarbietungen (gemäß den

Auftretenswahrscheinlichkeiten aus Tabelle 6.1)

wurden durchgeführt.

Resultate:

Durchschnittliche Informationstransmission

![]() bit

(das theoretische Maximum liegt, wie bereits erwähnt, bei 4.34 bit),

durchschnittliche Redundanz

bit

(das theoretische Maximum liegt, wie bereits erwähnt, bei 4.34 bit),

durchschnittliche Redundanz

![]() ,

durchschnittliche Abhängigkeit

,

durchschnittliche Abhängigkeit

![]() .

.

Experiment 12:

Wie Experiment 11, aber mit 10 Repräsentationsknoten.

Resultate:

![]() bit,

bit,

![]() ,

,

![]() .

.

Experiment 13:

Wie Experiment 12, aber mit 12 Repräsentationsknoten.

Resultate:

![]() bit,

bit,

![]() ,

,

![]() .

.

Experiment 14:

Wie Experiment 13, aber mit 14 Repräsentationsknoten.

Resultate:

![]() bit,

bit,

![]() ,

,

![]() .

.

Experiment 15:

Wie Experiment 14, aber mit 16 Repräsentationsknoten.

Resultate:

![]() bit,

bit,

![]() ,

,

![]() .

.

Aus den Experimenten 12 bis 15 ist ersichtlich, daß sich mit steigender Anzahl der Repräsentationsknoten die Informationsübertragung dem theoretischen Maximum annähert, während gleichzeitig die Redundanz innerhalb des Codes und auch die statistische Abhängigkeit der Codesymbole untereinander zunimmt. Dies verdeutlicht erneut den `trade-off' zwischen Informationstransmission und Redundanz: Optimale faktorielle Codierungen des Eingabeensembles wurden praktisch nie erreicht, hohe Informationsübertragung wurde durch den Verlust an Kompaktheit und statistischer Unabhängigkeit der Codekomponenten erkauft.

Dennoch wurde in allen Fällen eine bedeutende Redundanzreduktion erreicht (von 1341 Prozent Redundanz im Eingabeensemble auf deutlich unter 300 Prozent).

Eine der für die Reduktion der im DEC courier-Datensatz enthaltenen Redundanz brauchbarsten getesteten Vorgehensweisen war die folgende: Mit 16 Repräsentationsknoten (wie in Experiment 14) wurde das System solange mehrmals hintereinander von neuem zufällig initialisiert und daraufhin durch je 3000 Musterpräsentationen trainiert, bis das theoretische Optimum der Informationstransmission erreicht wurde (da in den Experimenten 12 - 14 Durchschnitte anhand von 10 Testläufen gebildet wurden, taucht die maximal mögliche wechselseitige Information zwischen Ein- und Ausgabe dort nie auf). Dieses Vorgehen entspricht der einfachsten Strategie zur Behandlung lokaler Maxima und erforderte meist nicht mehr als 5 sukzessive Läufe.

Zusätzliche Addition von uniform verteiltem Rauschen im Intervall ![]() auf die Aktivationen der Eingabeknoten während der

Trainingsphase erwies sich ebenfalls

zur Vermeidung lokaler Maxima als zweckmäßig.

auf die Aktivationen der Eingabeknoten während der

Trainingsphase erwies sich ebenfalls

zur Vermeidung lokaler Maxima als zweckmäßig.

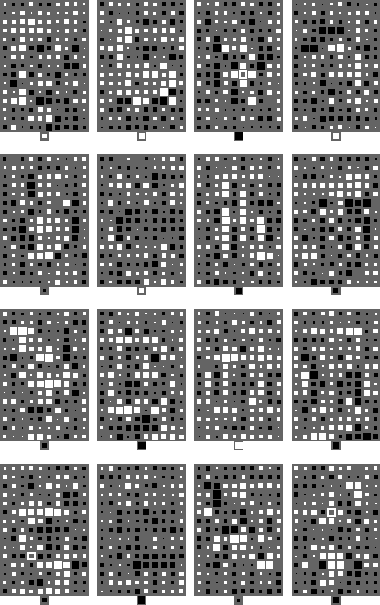

Welcher Art sind die `Objekte', die durch Vorhersagbarkeitsminimierung

aus dem Eingabeensemble extrahiert werden? Abbildung 6.3

veranschaulicht die Gewichte der Verbindungen zwischen den ![]() Eingabeknoten und jedem der 16 Repräsentationsknoten

nach dem Training.

Die 3. Matrix

in der 2. Reihe von oben steht beispielsweise für die Eingangsgewichte

des 7. Repräsentationsknotens (das einzelne Feld

unterhalb jeder Gewichtsmatrix steht für die Stärke der jeweiligen

Verbindung vom `bias'-Knoten).

Je positiver ein Gewicht, desto größer

das entsprechende weiße Quadrat.

Je negativer ein Gewicht, desto größer

das entsprechende schwarze Quadrat.

Eingabeknoten und jedem der 16 Repräsentationsknoten

nach dem Training.

Die 3. Matrix

in der 2. Reihe von oben steht beispielsweise für die Eingangsgewichte

des 7. Repräsentationsknotens (das einzelne Feld

unterhalb jeder Gewichtsmatrix steht für die Stärke der jeweiligen

Verbindung vom `bias'-Knoten).

Je positiver ein Gewicht, desto größer

das entsprechende weiße Quadrat.

Je negativer ein Gewicht, desto größer

das entsprechende schwarze Quadrat.

|

Aus Abbildung 6.3 geht hervor, daß die zur Redundanzminderung aus dem Datensatz extrahierten `Objekte' keine für menschliche Anschauung offensichtliche Interpretation besitzen, obwohl die Strukturen gewisse Regelmäßigkeiten aufweisen und gelegentlich bestimmte häufig auftretende Buchstabenteile eine Entsprechung in stark positiven oder stark negativen Eingangsgewichten finden (siehe beispielsweise die Matrix Nummer 13).