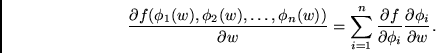

Bei gegebener Architektur und gegebenen Zielfunktionen verbleibt die formale Aufgabe der Ableitung des Lernalgorithmus. Hilfsmittel hierzu ist die Kettenregel. Sie sei für Funktionen mehrerer Veränderlicher an dieser Stelle in der für unser Anliegen zweckmäßigsten Weise formal niedergeschrieben:

Gegeben sei eine bezüglich all ihrer Parameter

differenzierbare Funktion

![]()

| (1.1) |

|

(1.2) |

![]() stellt bei unseren Anwendungen häufig ein

Performanzmaß oder aber auch bloß die Ausgabe eines

adaptiven Untermoduls dar,

stellt bei unseren Anwendungen häufig ein

Performanzmaß oder aber auch bloß die Ausgabe eines

adaptiven Untermoduls dar,

![]() bezeichnet in vielen Fällen die Aktivation eines

Knotens (möglicherweise aber auch die Ausgabe eines

weiteren Untermoduls), und

bezeichnet in vielen Fällen die Aktivation eines

Knotens (möglicherweise aber auch die Ausgabe eines

weiteren Untermoduls), und

![]() steht oft für einen Gewichtsparameter (vielleicht aber auch

für die Ausgabe

eines zu einem früheren Zeitpunkt aktiven Knotens oder Untermoduls).

steht oft für einen Gewichtsparameter (vielleicht aber auch

für die Ausgabe

eines zu einem früheren Zeitpunkt aktiven Knotens oder Untermoduls).