Nächste Seite: BEDINGTE VARIANZMAXIMIERUNG

Aufwärts: METHODEN ZUR DEFINITION VON

Vorherige Seite: INFOMAX

Inhalt

Ein Rekonstruktionsmodul  erhält

erhält

als Eingabe. Die Kombination von

als Eingabe. Die Kombination von  und

und  wird mittels BP trainiert, die

Rekonstruktion

wird mittels BP trainiert, die

Rekonstruktion  der externen Eingabe

der externen Eingabe

von

von  auszugeben. Die grundlegende

Architektur ist die eines Autoassoziators.

auszugeben. Die grundlegende

Architektur ist die eines Autoassoziators.

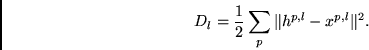

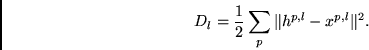

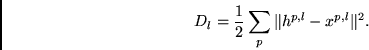

läßt sich dabei als der Rekonstruktionsfehler

läßt sich dabei als der Rekonstruktionsfehler

|

(5.16) |

definieren. Man werfe erneut einen Blick auf Abbildung 5.2.

Autoassoziatoren sind einfach zu implementieren.

Ein Nachteil der Methode liegt jedoch darin, daß die

vorhersagbare Information eines

Eingabemusters unter Umständen trotz Nichttrivialität

nichts dazu beiträgt, den Rekonstruktionsfehler zu minimieren

(als Beispiel diene das Stereoexperiment aus Abschnitt 5.5).

Juergen Schmidhuber

2003-02-20

Related links in English: Recurrent networks - Fast weights - Subgoal learning - Reinforcement learning and POMDPs - Unsupervised learning and ICA - Metalearning and learning to learn

Deutsche Heimseite